KI generierte Texte erkennen als ob es Ihre Muttersprache wäre

KI-generierte Texte zu entlarven, ist inzwischen eine Kernkompetenz im akademischen Alltag. Es geht im Kern darum, echte menschliche Denkleistung von maschinell erstellten Inhalten zu unterscheiden und so die akademische Integrität zu schützen. Mit den richtigen Strategien und einem geschulten Blick ist das aber gar nicht so schwer.

Warum das Erkennen von KI-Texten zur neuen Schlüsselkompetenz wird

Wir erleben gerade einen fundamentalen Wandel, wie an Hochschulen geschrieben und gearbeitet wird. Tools wie ChatGPT sind längst keine Spielerei mehr, sondern für viele Studierende ein fester Bestandteil ihres Arbeitsalltags – sei es für die erste Ideensammlung, die Gliederung oder eben auch für das Formulieren ganzer Textpassagen.

Für Lehrende und Hochschulen ist das eine echte Zerreißprobe: Wie bewertet man eine Leistung fair, wenn die Grenze zwischen eigener Arbeit und maschineller Hilfe immer unschärfer wird? Genau deshalb ist die Fähigkeit, KI-generierte Texte erkennen zu können, keine Nischenkompetenz mehr. Sie ist die Basis, um akademische Standards zu sichern und kritisches Denken zu fördern.

Die neue Normalität an den Hochschulen

Die KI-Welle ist längst an den Universitäten angekommen. Das ist keine vage Zukunftsvision, sondern gelebte Realität. Laut einer Studie des TÜV-Verbands haben bereits 53 Prozent der Deutschen Erfahrungen mit generativer KI gesammelt. Schaut man gezielt auf die Studierenden, ist die Zahl noch drastischer: Hier haben schon 78 Prozent KI-Tools genutzt.

Diese Zahlen machen eines klar: Wegschauen ist keine Option. Lehrende wie Studierende müssen sich aktiv damit auseinandersetzen, was diese Werkzeuge können – und wo ihre Grenzen und Gefahren liegen. Es geht dabei nicht darum, KI pauschal zu verbieten, sondern darum, einen bewussten und verantwortungsvollen Umgang damit zu entwickeln.

Der Schlüssel liegt nicht darin, die Technologie zu verteufeln, sondern darin, die menschliche Fähigkeit zur kritischen Analyse zu stärken. Nur so bleibt die akademische Arbeit authentisch und wertvoll.

Was auf dem Spiel steht

Wer KI im Studium einfach nur unreflektiert nutzt, riskiert mehr als nur eine schlechte Note. Wenn das eigenständige Formulieren, das schlüssige Argumentieren und die saubere Recherche in den Hintergrund rücken, gehen zentrale akademische Fähigkeiten verloren.

- Verlust kritischer Denkfähigkeit: Wer nur noch KI-Antworten kopiert, verlernt, Informationen selbst zu bewerten, abzuwägen und eigene Schlüsse zu ziehen.

- Aushöhlung der Prüfungsstandards: Die Fairness und Vergleichbarkeit von Noten leidet, wenn die Eigenleistung nicht mehr klar erkennbar ist.

- Gefahr von Fehlinformationen: KI-Modelle neigen zum "Halluzinieren". Das bedeutet, sie erfinden Fakten oder Quellen, die zwar überzeugend klingen, aber schlichtweg falsch sind.

Um diesen Gefahren zu begegnen, muss man die typischen Spuren von KI-Texten kennen. In unserem Leitfaden zu KI für wissenschaftliche Arbeiten zeigen wir, wie man diese Werkzeuge sinnvoll und erlaubt einsetzen kann. Dieser Artikel hier gibt Ihnen hingegen das Rüstzeug, um die Spuren der Maschine im Text zu finden.

So entlarven Sie KI-Texte mit geschultem Auge

Bevor wir zu den technischen Tools kommen, schärfen wir erst einmal die wichtigste Waffe im Arsenal: unser eigenes Urteilsvermögen. Oft reicht schon ein geschultes Auge, um nach wenigen Absätzen ein ungutes Gefühl zu bekommen. Es geht darum, die feinen, aber verräterischen Spuren zu erkennen, die eine Maschine im Text hinterlässt.

Die Fähigkeit, KI-generierte Texte erkennen zu können, beginnt nicht mit Software, sondern mit kritischem Lesen. Betrachten Sie den Text als Ganzes. Menschliche Texte haben Ecken und Kanten, einen eigenen Charakter. KI-Texte wirken dagegen oft zu perfekt, zu glatt, fast schon steril.

Achten Sie auf eine unnatürlich gleichmäßige Sprache

Ein klassisches Merkmal von KI-Texten ist ihre sprachliche Monotonie. Die Sätze plätschern in ähnlicher Länge und im selben Rhythmus vor sich hin. Es fehlt die natürliche Variation, die menschliches Schreiben ausmacht – mal ein kurzer, knackiger Satz, dann wieder ein längerer, der einen komplexen Gedanken entfaltet.

Stellen Sie sich vor, jemand liest Ihnen etwas mit einer absolut monotonen Stimme vor. Genau dieses Gefühl stellt sich bei vielen KI-Absätzen ein. Grammatikalisch ist alles korrekt, aber es fehlt die Melodie, die Dynamik.

Viele KI-Texte pflegen eine übertriebene Höflichkeit und eine fast schon klinisch reine Sprache. Sie ist oft gespickt mit Adjektiven, die mehr verschleiern als beschreiben. Statt einer individuellen Stimme liest man nur einen algorithmischen Durchschnitt.

Ein weiteres Warnsignal ist die Flut an Übergangsphrasen und Füllwörtern, die den Text künstlich aufblähen. Achten Sie auf gehäufte Formulierungen wie:

- „Zusammenfassend lässt sich sagen …“

- „Darüber hinaus ist es wichtig zu erwähnen …“

- „Es ist offensichtlich, dass …“

- „Im Hinblick auf …“

Diese Floskeln sind nicht per se falsch. Aber ihre penetrante Wiederholung ist ein starkes Indiz dafür, dass hier eine Maschine versucht hat, logische Brücken zu erzwingen, anstatt sie organisch wachsen zu lassen.

Das Fehlen einer persönlichen Stimme

Ein Mensch hat eine Haltung, eine Meinung, eine Perspektive. Diese persönliche Stimme prägt den Text, selbst bei einer rein sachlichen Arbeit. KI-Modelle haben keine eigenen Erfahrungen. Sie reproduzieren nur die Muster aus den Daten, mit denen sie trainiert wurden.

Das Ergebnis ist oft ein Text, der zwar viele Informationen liefert, aber keine Seele hat. Er fühlt sich an wie ein gut sortierter Wikipedia-Eintrag – informativ, ja, aber auch distanziert und unpersönlich. Fragen Sie sich beim Lesen:

- Spüre ich hier echte Begeisterung oder eine kritische Auseinandersetzung?

- Finde ich originelle Gedanken oder nur eine Aneinanderreihung bekannter Fakten?

- Wirkt der Text, als hätte ihn jemand geschrieben, der wirklich tief im Thema steckt?

Wenn Sie diese Fragen eher mit „Nein“ beantworten, sollten bei Ihnen die Alarmglocken schrillen. Wahre Expertise zeigt sich nicht nur in Fakten, sondern in der Art, wie diese gewichtet, interpretiert und miteinander verknüpft werden.

Inhaltliche Fehler und „Halluzinationen“ entlarven

Das ist vielleicht der sicherste Weg, um KI-generierte Texte erkennen zu können. Große Sprachmodelle neigen dazu, Fakten frei zu erfinden, wenn sie in ihren Trainingsdaten keine passende Antwort finden. Diese „Halluzinationen“ klingen oft täuschend echt, halten aber einer kurzen Überprüfung nicht stand.

Ein Klassiker ist die perfekt formatierte Quellenangabe zu einer Studie, die es gar nicht gibt. Oder ein Zitat, das einem berühmten Forscher in den Mund gelegt wird, von ihm aber nie stammt. Seien Sie besonders misstrauisch, wenn Quellenangaben vage bleiben oder direkte Links fehlen.

Checkliste zur inhaltlichen Prüfung:

- Quellen überprüfen: Suchen Sie nach den zitierten Artikeln oder Büchern. Existieren sie wirklich?

- Fakten verifizieren: Gleichen Sie konkrete Daten, Jahreszahlen oder Statistiken mit vertrauenswürdigen Quellen ab. Eine schnelle Onlinesuche reicht oft schon.

- Logik hinterfragen: Folgt die Argumentation einem roten Faden oder gibt es Sprünge und Widersprüche? KI-Texte springen manchmal von einem Punkt zum nächsten, ohne eine saubere Verbindung herzustellen.

Ein Kollege erzählte mir neulich von einer Hausarbeit, die er korrigierte. Darin wurde ein „führender deutscher Soziologe namens Dr. Klaus Weber“ mit einem beeindruckenden Zitat erwähnt. Eine kurze Recherche ergab: Es gab keinen bekannten Soziologen dieses Namens, der zu dem Thema publiziert hatte. Das Zitat war eine reine Erfindung der KI. Solche Funde sind der schlagende Beweis. Dieses „Bauchgefühl“ zu entwickeln, ist der erste und wichtigste Schritt, noch bevor Sie technische Helferlein einsetzen.

Welche KI-Detektoren wirklich funktionieren (und welche nicht)

Wenn das geschulte Auge allein nicht mehr weiterkommt, rücken technische Helfer in den Fokus. In den letzten Jahren ist der Markt für KI-Detektoren förmlich explodiert – angetrieben von einer spürbaren Unsicherheit in Unis, Schulen und Unternehmen. Die Anbieter versprechen eine einfache Lösung: Text rein, Knopf drücken und sofort wissen, ob eine Maschine am Werk war.

Ganz so einfach ist es in der Praxis aber leider nicht. Man muss sich klarmachen: Kein einziges dieser Tools ist unfehlbar. Die Ergebnisse sind immer nur Indizien, niemals harte Beweise. Bevor man also für einen Dienst bezahlt, sollte man verstehen, wie diese Detektoren überhaupt ticken, wo sie tatsächlich helfen können und – noch viel wichtiger – wo ihre systembedingten Schwachstellen liegen.

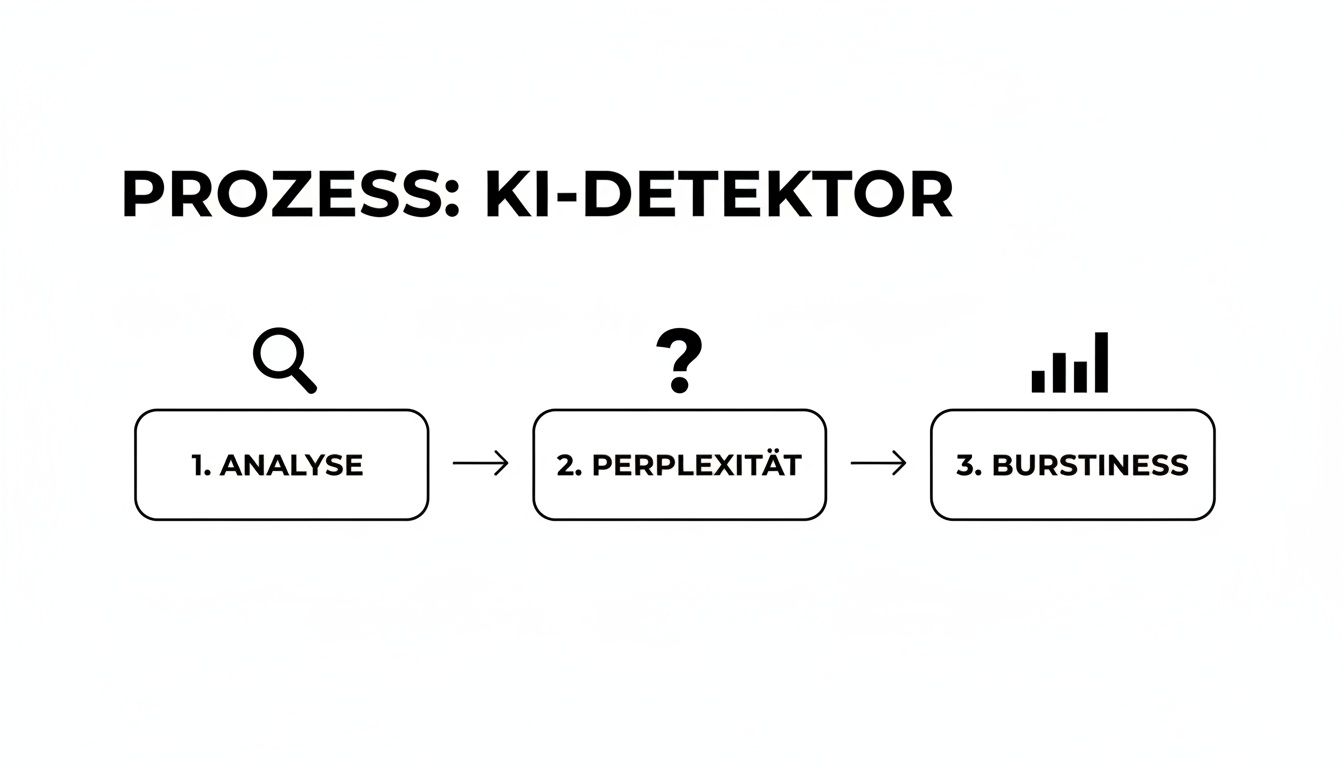

Ein Blick unter die Haube: Wie die Tools arbeiten

Im Grunde suchen diese Programme nach statistischen Mustern im Text, die für Maschinen typisch, für Menschen aber eher unüblich sind. Dabei stolpert man immer wieder über zwei Fachbegriffe: Perplexity und Burstiness.

Perplexity (oder „Verwunderung“): Das klingt komplizierter, als es ist. Im Kern misst dieser Wert, wie vorhersehbar ein Wort auf das vorherige folgt. Menschliche Sprache ist oft kreativ und überraschend – wir nutzen mal ein seltenes Synonym, machen einen gedanklichen Sprung oder formulieren einen Satz ganz bewusst ungewöhnlich. KI-Modelle neigen dagegen dazu, immer die statistisch wahrscheinlichste Option zu wählen. Ein Text mit sehr niedriger Perplexity ist also wenig „überraschend“ und damit ein starkes Indiz für eine KI.

Burstiness (oder „Gebündeltheit“): Hiermit ist die Abwechslung in der Satzlänge und -struktur gemeint. Menschen schreiben oft in „Schüben“ (Bursts) – mal ein kurzer, knackiger Satz, dann wieder ein längeres, verschachteltes Gebilde. KI-Texte wirken dagegen oft sehr gleichmäßig, fast schon monoton. Eine niedrige Burstiness deutet genau auf diese unnatürliche Gleichförmigkeit hin.

Das ist keine Zauberei, sondern pure Statistik. Die Tools analysieren die Wortwahrscheinlichkeiten und vergleichen sie mit dem, was für menschliche Sprache normal wäre.

Die bekanntesten Tools im Praxistest

Es gibt mittlerweile Dutzende Anbieter, aber ein paar Namen tauchen immer wieder auf. Schauen wir uns mal an, was die bekanntesten Detektoren wirklich leisten, gerade wenn es um deutschsprachige akademische Arbeiten geht.

GPTZero ist wahrscheinlich der bekannteste Vertreter und für viele die erste Anlaufstelle. Das Tool ist super einfach zu bedienen: Text reinkopieren und schon bekommt man eine prozentuale Einschätzung, wie wahrscheinlich der Text von einer KI stammt. Praktisch ist auch, dass besonders verdächtige Sätze farblich markiert werden.

Hier sieht man, wie die Analyseoberfläche von GPTZero ein klares Ergebnis liefert – in diesem Fall eine hohe Wahrscheinlichkeit für einen KI-generierten Text.

Diese visuelle Aufbereitung ist Gold wert, um sich schnell einen ersten Eindruck zu verschaffen und gezielt die Passagen zu prüfen, die dem Tool merkwürdig vorkommen.

Originality.ai will die professionellere Lösung sein. Der große Vorteil hier: Das Tool kombiniert die KI-Erkennung direkt mit einer klassischen Plagiatsprüfung. Die Analysen wirken oft etwas fundierter als bei vielen kostenlosen Diensten, aber auch hier gilt: Perfekt ist die Erkennung nicht, schon gar nicht im Deutschen.

Ganz wichtig: Die meisten dieser Detektoren wurden fast ausschließlich mit englischen Texten trainiert. Die Feinheiten der deutschen Grammatik, die komplexen Satzstrukturen und die idiomatischen Wendungen können sie oft nur unzureichend analysieren. Das Ergebnis ist eine spürbar höhere Fehlerquote, sowohl bei Falsch-Positiv- als auch bei Falsch-Negativ-Ergebnissen.

Der Hype um diese Tools ist eine logische Konsequenz. Weltweit nutzen bereits 65 Prozent der Firmen generative KI, um Inhalte zu erstellen. Und obwohl in Deutschland immerhin 51 Prozent der Unternehmen KI für Texte einsetzen, prüft nur etwa jeder Vierte die Ergebnisse kritisch nach. Das schafft eine riesige Nachfrage nach Detektoren, deren Trefferquoten oft nur zwischen 70 und 90 Prozent schwanken. Das zeigt, wie wichtig die Kombination aus Tool und menschlicher Prüfung ist. Mehr zu diesen Zahlen findet man in aktuellen KI-Statistiken und Trends.

Die unvermeidliche Fehlerquote

Machen wir uns nichts vor: Kein Detektor ist zu 100 % sicher. Das ist die wichtigste Erkenntnis, die man mitnehmen muss. Die Gründe dafür sind vielfältig:

- Menschliche Nachbearbeitung: Ein KI-Rohtext, der von einem Menschen geschickt überarbeitet, umformuliert und mit eigenen Gedanken angereichert wird, ist für die meisten Detektoren kaum noch zu erkennen.

- Immer bessere KI-Modelle: Jede neue Generation von Sprachmodellen (GPT-4o, Llama 3 etc.) wird besser darin, menschliches Schreiben zu imitieren. Die Detektoren hinken hier immer einen Schritt hinterher.

- Besondere Schreibstile: Jemand, der nicht in seiner Muttersprache schreibt oder einen sehr formellen, fast schon mechanischen Schreibstil pflegt, kann fälschlicherweise als KI-generiert eingestuft werden.

Ein rotes Fähnchen von einem KI-Detektor sollte daher niemals als alleiniger Beweis für einen Betrugsversuch herhalten. Es ist und bleibt ein Indiz – ein Anlass, genauer hinzusehen und eine manuelle Analyse zu starten.

Welches Tool für welchen Zweck?

| Tool | Stärken | Schwächen | Ideal für... |

|---|---|---|---|

| GPTZero | Sehr einfach, kostenlose Basisversion, schnelle Analyse | Bei bearbeiteten Texten ungenauer, stark auf Englisch fokussiert | Einen schnellen ersten Check, um ein Gefühl für das Thema zu bekommen |

| Originality.ai | Kombiniert KI- und Plagiatsprüfung, detailliertere Berichte | Kostenpflichtig, auch hier höhere Fehlerquote bei deutschen Texten | Detailliertere Analysen von Abschlussarbeiten, professioneller Einsatz |

Letztlich hängt die Wahl des Tools stark vom Anwendungsfall ab. Für eine schnelle Einschätzung reicht ein kostenloses Tool oft aus. Geht es aber um die fundierte Analyse einer wichtigen Arbeit, führt kein Weg an der Kombination aus einem professionellen Dienst und der eigenen, menschlichen Expertise vorbei.

Eine kombinierte Prüfstrategie in der Praxis

Grau ist alle Theorie. Das gilt ganz besonders, wenn man KI-generierte Texte sicher erkennen will. Die eigentliche Kunst liegt nämlich in der Anwendung. Deshalb gehen wir jetzt gemeinsam den entscheidenden Schritt von der Theorie zur Praxis und spielen eine kombinierte Prüfstrategie an drei typischen Textbeispielen durch.

Wir schauen uns zusammen drei Fälle an:

- Text A: Ein reiner, unveränderter Text, wie er direkt aus einem KI-Modell kommt.

- Text B: Ein KI-Text, der von jemandem gezielt überarbeitet wurde, um die maschinelle Herkunft zu verschleiern.

- Text C: Eine authentische Arbeit, die von einem Studierenden selbst verfasst wurde.

Anhand dieser Beispiele wird schnell klar, wie das Zusammenspiel aus menschlicher Analyse und technischer Unterstützung zu einem wirklich fundierten und fairen Ergebnis führt.

Der erste Durchgang: Auf das Bauchgefühl hören

Noch bevor wir irgendein Tool zurate ziehen, lesen wir uns die Texte einfach mal durch – aber mit dem geschulten Auge, das wir in den vorherigen Abschnitten entwickelt haben. Wir achten ganz gezielt auf den Stil, die Tonalität, den Aufbau der Argumente und natürlich die verwendeten Quellen.

Bei Text A, dem reinen KI-Text, springt einem die monotone, fast sterile Sprache sofort ins Auge. Die Sätze haben eine auffällig ähnliche Länge und werden mit abgedroschenen Phrasen wie „Darüber hinaus“ oder „Zusammenfassend lässt sich sagen“ aneinandergereiht. Man findet keine persönliche Note, keine überraschende Wendung – es liest sich wie ein gut sortierter, aber völlig seelenloser Lexikonartikel.

Text B, der bearbeitete KI-Text, ist schon eine härtere Nuss. Hier hat jemand die offensichtlichsten KI-Marker entfernt, die Satzlängen variiert und sogar eine kleine persönliche Anekdote eingebaut, um das Ganze menschlicher wirken zu lassen. Trotzdem bleibt ein Gefühl der Distanz. Die Argumente wirken zwar logisch, aber irgendwie nicht wirklich durchdrungen. Und spätestens bei den Quellen wird es interessant: Ein kritischer Blick zeigt, dass eine zitierte Studie zwar plausibel klingt, es sie aber gar nicht gibt. Eine klassische KI-Halluzination, die bei der Überarbeitung übersehen wurde.

Ganz anders dagegen Text C, die studentische Arbeit. Der Text hat Ecken und Kanten. Hier und da gibt es vielleicht kleine stilistische Unsicherheiten oder einen komplizierten Schachtelsatz, der nicht ganz rund ist. Aber genau diese „Unvollkommenheit“ schreit förmlich nach Authentizität. Man spürt, wie sich der Autor mit dem Thema auseinandergesetzt hat, eine echte argumentative Entwicklung stattfindet und eine klare, persönliche Stimme durchscheint.

Die technische Analyse mit KI-Detektoren

Nach dieser ersten Einschätzung schicken wir alle drei Texte durch einen KI-Detektor wie GPTZero. Es geht hier nicht darum, unser eigenes Urteil zu ersetzen. Vielmehr wollen wir es mit statistischen Daten untermauern oder vielleicht auch hinterfragen.

Wie so ein Detektor im Kern funktioniert, veranschaulicht die folgende Grafik. Er analysiert Metriken wie Perplexität (Wie überraschend ist ein Wort?) und Burstiness (Wie abwechslungsreich ist der Satzbau?).

Diese Analyse basiert auf der statistischen Vorhersehbarkeit von Sprache – und genau das ist eine der Kernschwächen von KI-Texten.

Die Ergebnisse der Tool-Analyse bestätigen nicht nur unsere Vermutungen, sondern liefern auch spannende neue Details:

Text A wird vom Detektor mit einer 98 %igen Wahrscheinlichkeit als KI-generiert eingestuft. Die Software markiert fast jeden Satz als extrem vorhersehbar. Das Ergebnis ist glasklar und passt perfekt zu unserer manuellen Analyse.

Text B liefert ein gemischtes Bild. Der Detektor spuckt eine Wahrscheinlichkeit von nur 45 % aus und hebt nur noch einzelne Abschnitte als potenziell maschinell erstellt hervor. Das zeigt eindrücklich, wo die Grenzen der Tools liegen: Menschliche Nachbearbeitung kann die statistischen Muster so stark aufbrechen, dass eine klare Erkennung schwierig wird. Ohne unsere manuelle Quellenprüfung wäre uns die erfundene Studie glatt durchgerutscht.

Text C erhält vom Tool eine Bewertung von nur 8 % für eine mögliche KI-Herkunft. Dieses Ergebnis untermauert unsere Einschätzung, dass es sich um eine authentische Arbeit handelt, ganz erheblich.

Merke: KI-Detektoren sind wertvolle Assistenten, aber schlechte Richter. Ein hohes Ergebnis kann einen Verdacht erhärten, ein niedriges oder gemischtes Ergebnis widerlegt ihn jedoch nicht automatisch.

Das Puzzle zusammensetzen: Mensch und Maschine im Dialog

Der entscheidende Schritt ist jetzt, beide Perspektiven zusammenzuführen. Wir legen die Beobachtungen aus unserer Analyse neben die Daten des Detektors und fällen daraus ein Gesamturteil.

| Kriterium | Text A (Reine KI) | Text B (Bearbeitete KI) | Text C (Menschlich) |

|---|---|---|---|

| Sprachlicher Eindruck | Monoton, steril, unpersönlich | Variabler, aber distanziert | Lebendig, authentisch, persönlich |

| Argumentation | Logisch, aber oberflächlich | Logisch, aber ohne Tiefe | Entwickelt, mit eigener Haltung |

| Quellenprüfung | Korrekt, aber generisch | Enthält eine erfundene Quelle | Korrekt und nachvollziehbar |

| KI-Detektor-Score | 98 % (sehr hoch) | 45 % (uneindeutig) | 8 % (sehr niedrig) |

Die Kombination der Ergebnisse macht das Bild plötzlich ganz klar. Bei Text A sind sich Mensch und Maschine einig. Bei Text B hätte uns das Tool allein im Stich gelassen; erst die manuelle Faktenprüfung lieferte den entscheidenden Hinweis. Und bei Text C bestätigen sich beide Methoden gegenseitig auf ideale Weise.

Gerade die Überprüfung von Zitaten und Quellen ist ein unglaublich mächtiges Werkzeug, da KI-Modelle hier oft Fehler machen, die für einen Menschen mit ein paar Klicks zu finden sind. Falls Sie sich unsicher sind, wie eine gründliche Quellenprüfung abläuft, finden Sie in unserer Demonstration zur Zitatprüfung einige praktische Beispiele.

Diese kombinierte Strategie bewahrt Sie vor voreiligen Schlüssen und falschen Anschuldigungen. Sie ermöglicht eine faire, nachvollziehbare und evidenzbasierte Bewertung, die die feinen Nuancen menschlicher Intuition mit der statistischen Kraft der Technologie verbindet.

Umgang mit den Grenzen der KI-Erkennung

Die Vorstellung, eine Software könnte uns auf Knopfdruck eine hundertprozentige Gewissheit liefern, ist verlockend, aber leider eine Illusion. Ganz ehrlich: Wer behauptet, KI-generierte Texte erkennen zu können, und das ohne jedes Wenn und Aber, ist nicht seriös. Wir bewegen uns hier in einer komplexen Grauzone, denn selbst die besten Detektoren stoßen an klare Grenzen.

Genau diese Grenzen zu verstehen ist entscheidend. Nur so können wir die Tools verantwortungsvoll einsetzen und, noch wichtiger, niemanden fälschlicherweise an den Pranger stellen.

Ein Hauptproblem ist das schwindelerregende Tempo, mit dem sich KI-Modelle weiterentwickeln. Jede neue Generation wird cleverer darin, menschliche Schreibstile zu imitieren und genau die statistischen Muster zu vermeiden, nach denen die Detektoren fahnden. Ein Text, der von einem topaktuellen Sprachmodell stammt, kann heute schon so überzeugend klingen, dass er für viele Tools praktisch unsichtbar bleibt.

Die Gefahr der Falschbeschuldigung

Richtig heikel wird es, wenn menschliche Arbeit fälschlicherweise als maschinell eingestuft wird. Das Risiko solcher „Falsch-Positiv-Ergebnisse“ ist absolut real und kann verheerende Konsequenzen haben.

Ein KI-Detektor-Ergebnis darf niemals der alleinige Beweis für einen Täuschungsversuch sein. Es ist lediglich ein Indikator, ein Bauchgefühl der Maschine, das eine genauere, menschliche Prüfung anstoßen sollte – mehr nicht.

Besonders im Fokus stehen hier bestimmte Personengruppen, die ungewollt ins Visier der Algorithmen geraten können:

- Nicht-Muttersprachler: Wer auf Deutsch schreibt, obwohl es nicht die eigene Erstsprache ist, greift oft auf einfachere Satzstrukturen und einen etwas formelhafteren Wortschatz zurück. Die Texte haben dadurch eine geringere sprachliche Komplexität (Perplexity), was Detektoren schnell als KI-Merkmal fehlinterpretieren.

- Personen mit neurodivergenten Zügen: Ein sehr sachlicher, direkter oder repetitiver Schreibstil, wie er beispielsweise bei manchen Menschen im Autismus-Spektrum vorkommt, kann ebenfalls fälschlicherweise als maschinell markiert werden.

- Schreibanfänger: Studierende am Anfang ihres Studiums, die sich noch stark an formale Vorgaben klammern, produzieren oft Texte, die weniger individuell und „glatter“ wirken – ein gefundenes Fressen für die Mustererkennung der Tools.

Diese Beispiele machen deutlich, wie schnell eine rein technische Bewertung in eine ungerechte und diskriminierende Anschuldigung umschlagen kann.

Wenn der Mensch die KI tarnt

Die größte Herausforderung für jede Form der Erkennung ist aber die Zusammenarbeit von Mensch und Maschine. Wenn ein Studierender einen KI-generierten Rohtext als Grundlage nimmt und diesen anschließend sorgfältig überarbeitet, Sätze umstellt, eigene Gedanken einfügt und den Stil anpasst, verwischen die Spuren fast vollständig.

Solche hybriden Texte sind die Achillesferse der Detektoren. Die statistischen Fingerabdrücke der KI werden durch die menschliche Bearbeitung so stark aufgebrochen, dass die Software keine klaren Signale mehr findet.

In diesen Fällen ist die manuelle Prüfung der einzig verlässliche Weg. Nur ein Mensch kann die Argumentationstiefe, die Qualität der Quellen und die persönliche „Stimme“ im Text wirklich beurteilen. Anleitungen, wie man eine solche KI Hausarbeit schreiben und nachbearbeiten kann, um die maschinelle Herkunft zu verschleiern, kursieren längst und erschweren die Erkennung zusätzlich.

Empfehlungen für einen fairen Umgang

Für Lehrende bedeutet das vor allem eines: Ein Verdachtsmoment darf niemals zu einer sofortigen Konsequenz führen. Stattdessen braucht es einen transparenten und fairen Prozess.

- Das Gespräch suchen: Konfrontieren Sie die betreffende Person nicht mit einem Vorwurf. Suchen Sie das Gespräch über die Arbeit und stellen Sie offene Fragen zum Inhalt, zur Argumentation und zum Entstehungsprozess.

- Inhaltliche Prüfung vertiefen: Bitten Sie um eine mündliche Erläuterung komplexer Passagen. Wer eine Arbeit selbst geschrieben hat, kann seine Gedankengänge in der Regel auch frei erläutern.

- Mehrere Indizien sammeln: Ein einzelnes Detektor-Ergebnis ist für sich genommen wertlos. Es braucht weitere Anhaltspunkte – etwa inhaltliche Brüche, erfundene Quellen oder eine auffällige stilistische Abweichung von früheren Arbeiten derselben Person.

Häufig gestellte Fragen: KI-Texte im Uni-Alltag

Immer wieder tauchen dieselben dringenden Fragen auf, wenn es um KI-Texte im Studium geht. Hier finden Sie klare Antworten und eine schnelle Orientierung für die häufigsten Unsicherheiten.

Kann man KI-Texte zu 100 % sicher erkennen?

Die kurze Antwort: Nein, eine hundertprozentige Sicherheit gibt es nicht. Moderne Sprachmodelle sind erschreckend gut darin, menschliche Schreibstile nachzuahmen. Spätestens wenn ein KI-Text von einem Menschen überarbeitet und verfeinert wird, stoßen die meisten Detektoren an ihre Grenzen.

Der einzig sinnvolle Weg ist daher eine Kombination aus Ihrem kritischen Blick und der unterstützenden Hilfe von Tools.

Verstehen Sie das Ergebnis eines Detektors als Hinweis, niemals als Beweis. Es ist der Startpunkt für eine genauere manuelle Analyse, nicht das endgültige Urteil.

Letztendlich führt nichts an der Kombination vorbei: Stilistische Analyse, kritische Faktenprüfung und ein technischer Gegencheck – das ist der verlässlichste Ansatz.

Was droht eigentlich bei unerlaubter KI-Nutzung?

Die Konsequenzen hängen von der jeweiligen Hochschule und Prüfungsordnung ab, sind aber fast immer ernst. Die unerlaubte Nutzung von KI wird in der Regel wie ein klassisches Plagiat behandelt – also als Täuschungsversuch gewertet.

Die Sanktionen können dabei von einer einfachen Verwarnung bis hin zur Exmatrikulation reichen:

- Durchgefallen: Die Arbeit wird mit der schlechtesten Note bewertet.

- Offizieller Verweis: Ein Tadel, der in Ihrer Akte vermerkt wird und zukünftige Bewertungen beeinflussen kann.

- Exmatrikulation: Bei schweren oder wiederholten Fällen ist dies die härteste Konsequenz.

Viele Universitäten sind gerade dabei, ihre Richtlinien an die neue Technik anzupassen. Informieren Sie sich deshalb unbedingt proaktiv und verbindlich bei Ihrem Fachbereich oder Prüfungsamt, was genau erlaubt ist und was nicht. So vermeiden Sie es, unwissentlich gegen die Regeln zu verstoßen.

Funktionieren die KI-Detektoren auch für deutsche Texte zuverlässig?

Das ist ein entscheidender Punkt. Die meisten bekannten Detektoren, wie GPTZero oder Originality.ai, wurden mit einem riesigen Korpus an englischen Texten trainiert. Ihre Treffsicherheit für deutsche Texte wird zwar besser, ist aber oft noch spürbar ungenauer.

Die deutsche Grammatik mit ihren komplexen Satzstrukturen und typischen Redewendungen stellt für diese Tools eine echte Hürde dar. Das Ergebnis ist eine höhere Fehlerquote – sowohl bei Falsch-Positiv-Ergebnissen (menschlicher Text wird als KI markiert) als auch andersherum.

Gerade bei deutschen Texten ist es deshalb extrem wichtig, sich nicht blind auf ein Tool zu verlassen. Die manuelle Prüfung von Inhalt, Argumentation, Stil und Quellen muss hier immer an erster Stelle stehen. Die Tools sind eine Ergänzung, aber ihre Ergebnisse sollten Sie mit besonderer Vorsicht genießen.

Sind KI-Texte immer schlechter als von Menschen geschriebene?

Nicht zwangsläufig. Eine KI kann in Sekunden grammatikalisch saubere, gut strukturierte und informative Texte produzieren. Was reine Informationsdichte und sprachliche Korrektheit angeht, können sie menschlichen Texten manchmal sogar überlegen sein.

Der entscheidende Unterschied liegt aber woanders. Einer KI fehlen:

- Echte Originalität: Sie kombiniert nur bekannte Informationen neu, schafft aber keine wirklich neuen Einsichten.

- Persönliche Stimme: Sie kann keine echten Erfahrungen, Emotionen oder eine fundierte, persönliche Haltung einbringen.

- Tiefes kritisches Denken: Sie gibt Argumente wieder, kann sie aber nicht wirklich abwägen, hinterfragen oder eine eigenständige, komplexe These entwickeln.

Ein menschlicher Text hat vielleicht stilistische Mängel, aber er transportiert im besten Fall eine authentische Auseinandersetzung mit dem Thema. Und genau das ist der unschätzbare Wert, den menschliche Autorenschaft ausmacht.

Die Abgabefrist für die Hausarbeit rückt näher, aber die Zeit wird knapp? IntelliSchreiber erstellt Ihnen in wenigen Minuten eine vollständige, plagiatsfreie Arbeit mit echten, überprüfbaren Quellen. Sparen Sie sich den Stress und erhalten Sie ein hochwertiges Ergebnis, das Sie direkt verwenden können. Testen Sie IntelliSchreiber jetzt und erleben Sie, wie einfach wissenschaftliches Arbeiten sein kann.